Virtual Reality steht noch am Anfang seiner Entwicklung. Wir wagen anhand bekannter Technologie einen Blick in die nahe Zukunft.

Die ferne VR-Zukunft mögen wir nicht prognostizieren – einzig an einen dauerhaften Erfolg von Virtual Reality glauben wir weiterhin fest. Und zwar auch bei Games aber vor allem in der Berufswelt. Zu vielfältig sind die bereits bekannten Einsatzmöglichkeiten, von Präsentationen bis hin zum Einsatz in Wissenschaft, Medizin und Lehre.

Seit 2016 sind VR-Headsets der ersten modernen Generation auf dem Markt, damals starteten Oculus Rift und HTC Vive in den Markt nachdem bereits in den 1990ern ein VR-Strohfeuer schnell wieder verschwand. Was die grundlegende Technik anging, ähnelten sich die beiden HMDs recht stark, bis hin zur identischen Auflösung und einem Field of View von etwa 110 Grad. Bei Linsen, Tracking und Controllern gab es hingegen größere Unterschiede, bis heute. Seitdem sind mit Sony Playstation VR, Windows Mixed Reality und diversen auf Smartphonetechnik basierenden Lösungen bis hin zur Oculus Go zahlreiche weitere VR-Brillen erschienen – allen gemein ist übrigens weiterhin ein Field of View von etwa 110 Grad horizontal.

Selbst Oculus sprach bei der Präsentation der autarken VR-Brille Oculus Quest von „der letzten Oculus-Brille der ersten Generation“. Wie weit Oculus den Generationenbegriff fasst ist nicht bekannt, ein größeres Field of View dürfte aber auch bei Oculus auf der Checkliste stehen.

Wide-FoV – weg mit der Taucherbrille

Damit hätten wir ein Merkmal der zweiten VR-Generation, für einige Pimax-Nutzer vielleicht das wichtigste. Der größere Sichtwinkel, der sich mit bis zu 170 Grad horizontalem FoV schon deutlich stärker dem menschlichen Sichtfeld von etwa 180 Grad nahekommt, macht tatsächlich einen großen Unterschied. Wie präsent der Taucherbrilleneffekt bei Vive, Rift, PSVR und WMR ist fällt aber zum Glück meist erst auf, nachdem man das größere FoV selbst gesehen hat. Es erinnert an die Schwierigkeiten, Flatgamern VR zu erklären – selbst VR-Enthusiasten können den Vorteil des größeren FoV oft nur schwer einschätzen. Ich schließe mich da übrigens ein, dafür war es umso schwerer, den Blick durch das 110-Grad-Fernglas zu akzeptieren nachdem ich die Pimax-Brillen ja leider im MRTV-Hauptquartier lassen musste.

Auch Valve arbeitet gerüchteweise an einer eigenen VR-Brille oder der Blaupause für ein Valve-HMD, das dann andere Unternehmen produzieren und vermarkten. Hoffentlich etwas enthusiastischer als Microsoft es mit WMR tut. Auch diesem wird ein größeres FoV im Bereich um 130 bis 150 Grad nachgesagt. Mit der glücklosen StarVR und dem ebenfalls für professionelle Nutzer gedachten Xtal-Headsets gibt es weitere VR-Brillen mit großem FoV. Es dürfte nur logisch sein, dass auch die in Zusammenarbeit mit VoodooDE, MRTV und SweViver geplante Consumer-Xtal der VRgineers auf ein größeres Field of View setzen wird. Mit dem Half-Dome-Prototypen hat auch Oculus eine VR-Brille mit größerem FoV (130 Grad) gezeigt, allerdings haben sich die Prioritäten bei Oculus inzwischen etwas vom PC entfernt, so dass unklar ist, wann ein Produkt dazu erscheinen könnte.

Ein Nachteil größerer Sichtfelder sind bislang Verzerrungen in den Randbereichen. Probleme mit fehlender GPU-Leistung, die durch die zwangsweise steigende Auflösung der VR-Displays (immerhin muss jetzt ein größerer Bildbereich dargestellt werden und, Hardwarevergleich: ein 39-Zoll-Monitor 21:9 wirkt mit FullHD auch eher grobpixelig, erledigen sich durch kommende GPU-Generationen immerhin fast von selbst.

Distortions lassen sich ein wenig eindämmen, wenn der Augenabstand, IPD, möglichst perfekt eingestellt ist. Bei Vive und Rift sind kleinere Abweichungen zwischen eingestellter IPD und echtem Augenabstand kaum wahrzunehmen, bei Wide-FoV-Headsets äußern sie sich aber unter Umständen in stärkeren Distortions. Es ist daher naheliegend, dass beispielsweise StarVR und Xtal die IPD per Eye-Tracking-Modul automatisch einstellen.

Eye-Tracking mit vielen Vorzügen für VR

Eye-Tracking könnte sich bereits in naher Zukunft als Standardfeature neuer VR-Headsets und damit als Merkmal der zweiten Generation etablieren. Auf der CES im Januar 2019 waren bereits einige gut lauffähige Eye-Tracking-Demonstrationen beispielsweise bei HTC und Pimax zu testen. HTC präsentierte mit der HTC Vive Pro Eye sogar eine für professionelle Nutzer ausgelegte VR-Brille in Form einer um Eyetracking (von Tobii) erweiterten Vive Pro. Der Preis dürfte entsprechend erschreckend ausfallen, der Weg ist aber erkennbar.

Auch Pimax arbeitet an Eyetracking, das als Nachrüst-Modul für die Pimax 5K+ und 8K erscheinen soll. Eine rasche Adaption seitens der Softwareindustrie ist anzunehmen: Eye-Tracking kann zahlreiche interessante Daten über die Nutzung der jeweiligen VR-App an die Firmen liefern. Wie lange schaut der Spieler auf welche Symbole, wo wandert der Blick der meisten Spieler zuerst hin – so lassen sich packende Spielszenen noch packender gestalten. Schauen wir mit den Augen auf ein Bedienfeld könnte sich die damit verbundene Tür automatisch öffnen – was sich schon ein wenig wie Gedankenlesen anfühlt.. Aber, jetzt wirds finanziell interessanter: Auch kommende VR-Webshops können messen, welche Teile der Webseite wie lange und intensiv angeschaut wurden und worauf die Nutzer offenbar besonders viel Wert legen. Produktentwickler dürften sich für solche Daten ebenso interessieren wie das Marketing.

Foveated Rendering spart Performance

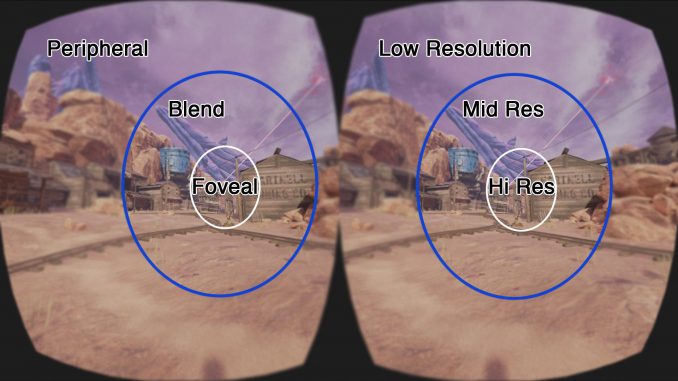

Etwas kniffliger sieht es bei der zweiten wichtigen Nutzung von Eye-Tracking aus: Wenn die VR-Brille schon weiß, wo meine Augen genau hinschauen, dann ist es möglich, nur diesen Bereich mit maximaler Auflösung oder Bildqualität zu berechnen. Genau das passiert beim Foveated Rendering, das den Effekt ausnutzt, dass das menschliche Auge nur im Bereich der Fovea, der Sehgrube, wirklich alle Details wahrnehmen. Je weiter wir uns vom Zentrum entfernen, desto weniger Details sind nötig ohne dass unser Gehirn einen Unterschied bemerkt.

So lässt sich enorm Grafikleistung einsparen, es wird aber auch schon an Foveated WLAN gearbeitet um PC-VR kabellos zu gestalten ohne auf teure und komplizierte 60-GHz-Funkstrecken zurückgreifen zu müssen oder mit bestehender Technik auch hochauflösende 5K- und 8K-Brillen kabellos nutzbar zu machen. Dabei wird nur der tatsächlich fokussierte Bildbereich in geringer Kompression übertragen, die nötige Bandbreite sinkt auf ein Drittel des Ursprungs und das ohne sichtbaren Qualitätsverlust.

Allerdings erfordert Foveated Rendering stärkere Softwareeingriffe, auch seitens der Grafikkartenhersteller und ihrer Treiber. Es wäre spannend, zu dem Thema einen Talk mit einem VR-Dev zu halten – schreibt doch mal in die Kommentare ob ihr daran Interesse hättet.

Hand- und Finger-Tracking mit Leap Motion

Eine Konsole durch bl0ßes dahinschauen bedienen klingt zwar cool, ist aber genauso unrealistisch wie die Simulation von Fingern durch die Vive Wands. Hand-Tracking wäre eine intuitive Methode, die eigenen Finger naturgetreu im Spiel einzusetzen. Leap Motion fertigt schon seit Jahren entsprechende Kameras, die sich aber erst jetzt mit Virtual Reality größerer Aufmerksamkeit erfreuen. Ich habe Leap Motion recht früh nach dem Marktstart für Notebookcheck getestet, hier sehr ihr das Video dazu:

Seitdem hat sich einiges getan – damals war mein größter Kritikpunkt, dass die Hardware gut funktioniert, die Software allerdings noch suboptimal arbeitet. In den vergangenen Jahren konnten die Entwickler wichtige Erfahrungen sammeln, dazu kommt, dass Hand-Tracking aus der VR-Perspektive deutlich angenehmer ist als bei der Umsetzung auf einem flachen Monitor. Pimax bietet ein Leap-Motion-Modul als Erweiterung der 5K+ und 8K an, das auf den unteren USB-C andockt. Auch andere (Highend-) Hersteller nutzen Leap Motion für das Tracking von Händen und Fingern, so dass wir Hand-Tracking wohl ohne schlechtes Gewissen eine große Zukunft für VR vorhersagen.

Chris Roberts mag Leap Motion und Oculus Rift

Das hat übrigens auch Chris Roberts, Verantwortlich für Meilensteine wie Wing Commander und aktuell mit Star Citizen ausgelastet. Kurz nach dem Kickstartererfolg von Star Citizen hatte ich die Gelegenheit für ein Interview mit Roberts und natürlich sprachen wir auch über Virtual Reality:

// Dennis:

Mit Star Citizen unterstützt du neue Eingabegeräte wie die Bewegungssteuerung Leap Motion – was denkst du persönlich über Leap Motion und Microsofts Kinect?

// Chris:

Es ist spannend damit zu experimentieren, Leap Motion beispielsweise kann die Spielerfahrung deutlich verbessern. Kinect allerdings habe ich in der PC-Version ausprobiert und war nicht sehr begeistert. Leap Motion ist da besser auf den PC abgestimmt – du brauchst auch weniger Platz um es zu benutzen und kannst mit deinem Stuhl vor dem PC sitzen bleiben.

// Dennis:

Außerdem eignet sich Leap Motion sicherlich gut als Ergänzung von VR-Brillen wie Oculus Rift..?

// Chris:

So ist es, die Oculus-Entwickler sind auch sehr an Leap Motion interessiert, die beiden Geräte ergänzen sich sehr gut. Wir haben momentan eine sehr spannende Zeit mit vielen coolen technischen Neuentwicklungen. Viele davon schaffen es allerdings nicht zum Mainstream, weil es keine Software gibt, die sie unterstützt. Das will ich mit Star Citizen ändern und ich bin guter Dinge, dass wir uns da sehr gut unterstützen. Es ist schade, dass viele innovative Möglichkeiten nicht genutzt werden.

Auch wenn diese Worte aus dem Jahre 2012 stammen und seitdem nicht mehr viel über Leap Motion und VR-Support bei Star Citizen zu hören war, Chris‘ Begeisterung für die volle Immersion lässt hoffen:

// Dennis:

Du bist also auf dem Weg zu deinem ganz persönlichen Holodeck?

// Chris:

Genau, das ist exakt das was ich schon immer wollte! Wir unterstützen Oculus Rift auf jeden Fall.

Schlauere KI-Gesellen für mehr Immersion

Wie sich der Einsatz realistisch wirkender Physik in der virtuellen Realität auswirken kann beweisen Spiele wie Blade and Sorcery: Es lässt sich nicht nur herrlich viel Unfug damit anstellen, die Spielwelt wirkt auch glaubhafter wenn sich alle Gegenstände und Personen an gängige physikalische Regeln halten. Die unzähligen Recheneinheiten von CPU und GPU simulieren hier vor einigen Jahren noch nicht denkbare Physik – es wird Zeit für den nächsten Schritt. Singleplayer-Spiele, vor allem storybasierte, leiden noch immer unter arg dämlichen KI-Mitstreitern. Künstliche Intelligenz ist aber momentan ein Hype-Thema, so dass wohl auch Spiele bald etwas pfiffigere Persönlichkeiten bieten werden.

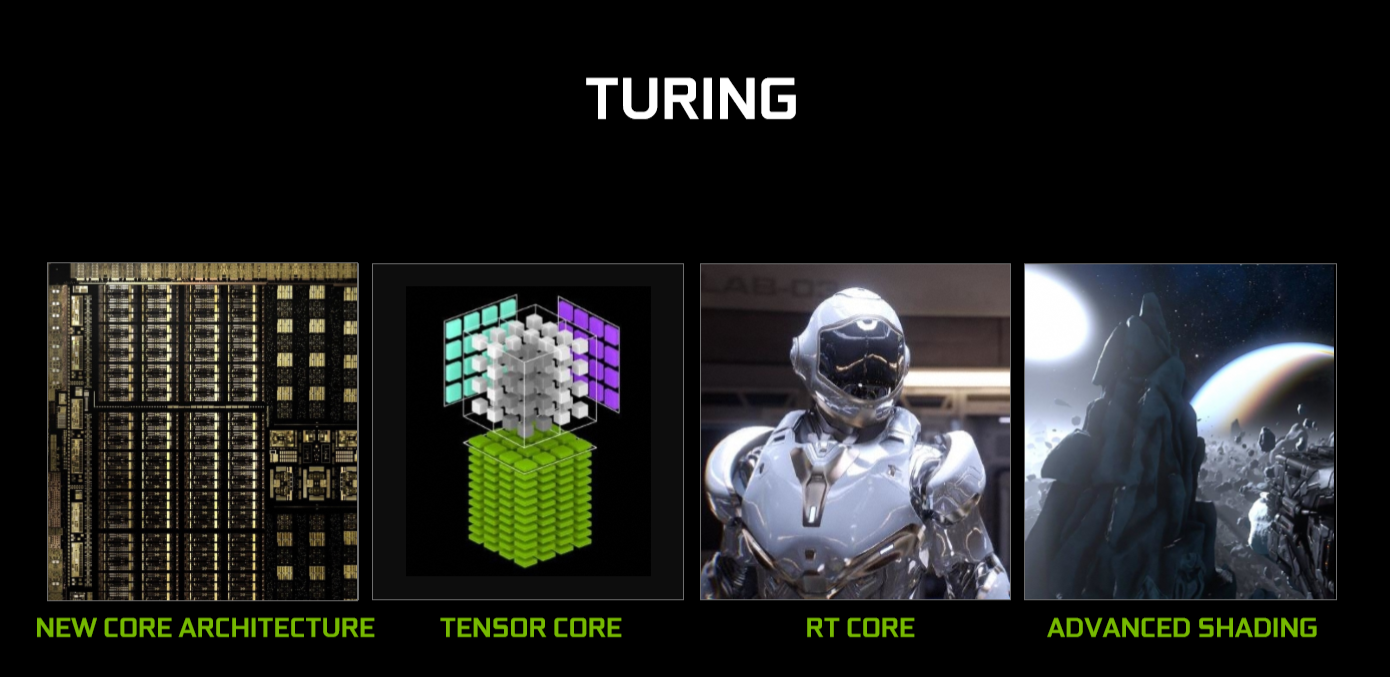

Und damit meine ich nicht nur bessere KI-Bots für Multiplayergefechte sondern vor allem NPCs bespielsweise in Rollenspielen. Wenn die KI-Figuren nicht nur ihre zwei, drei Standardsätze absondern sondern halbwegs nachvollziehbar auf unsere Handlungen reagieren beispielsweise. In Nvidias RTX-Grafikkarten stecken bereits Rechenkerne die sich fürs Deep-Learning eignen, mit PhysX hat Nvidia zudem eine GPU-beschleunigte Physiksimulation im Angebot. Was liegt näher, als auch KI-Beratern auf Shoppingseiten oder KI-Mitstreitern im Computerspiel etwas mehr Pfiffigkeit zu verpassen?

Träumen wir doch einmal etwas: Von einem VR-Rollenspiel, das Schwertkämpfe inszeniert wie Blade and Sorcery, sich beim Bogenschießen von In Death inspirieren lässt und in dem sich die KI-Figuren zumindest annähernd realistisch verhalten weil deutlich mehr Rechenleistung für eine ausgefeilte künstliche Intelligenz vorhanden ist. KI-Persönlichkeiten, die auf unsere Augenbewegungen genauso reagieren können wie auf unsere Stimme. Denn natürlich sollte auch angesichts der Entwicklungen bei Alexa und co. die natürliche Ausdrucksform per Sprache auch in Spielen Einzug erhalten. Und damit meine ich nicht nur „so oft wie möglich Fireball rufen“ weil der Entwickler Voice-Commands mit Mausklickgeschwindigkeit fordert.

Sprache muss realistisch eingesetzt werden, kein Magier wird sich auf dem Schlachtfeld den Mund fusselig brüllen weil er jede Mini-Feuerkugel einzeln herbeiruft. Aber ein mit den Händen (per Leap Motion) gewebter Zauberspruch, der mit einem magischen Wort genutzt wird und sparsam eingesetzt wird wäre doch ein Anfang um mehrere Technologien zu kombinieren. Bis wir mit NPCs aber in flüssiger Sprache kommunizieren wird es noch ein paar Jahre länger dauern.

Spannend werden in diesem Zusammenhang auch automatische Übersetzungsdienste. Mit Mitstreitern aus Asien das MMO unsicher machen wird in einigen Jahren nicht mehr an der Sprachbarriere scheitern, selbst Voicechat dürfte sich in absehbarer Zeit ohne größere Latenzen live übersetzen lassen.

5G-Streaming für die volle Mobilität

Auch heute schon streamen einige VR-Nutzer Inhalte auf ihre PC-VR-Brille: Mit Vive Wireless oder TPCast. Allerdings mit hohem technischen Aufwand und Hardware im 60-GHz-Frequenzband. Mit dem kommenden Mobilfunkstandard 5G soll VR-Streaming auch auf mobilen Headsets funktionieren. Dafür muss zwar noch einiges an 5G-Infrastruktur aufgebaut werden und auch an der Kompression müssen die Hersteller noch arbeiten – 5G wird aber schon jetzt als Hoffnungsbringer für mobile VR gehandelt. Unabhängig von Smartphone-Hardware oder PC hochwertige VR-Inhalte einfach so auf die VR-Brille streamen – das wird noch ein paar Jahre dauern, dürfte dann aber tatsächlich durchschlagenden Erfolg haben.

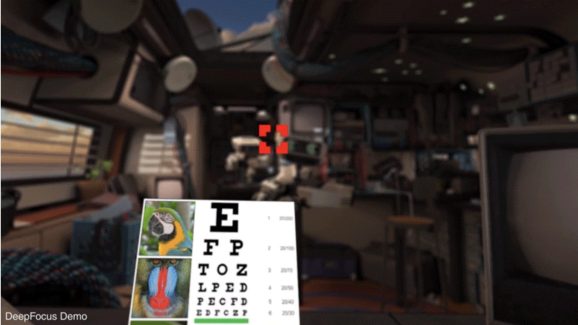

Variofocal-Displays

In etwas weiterer Ferne ist ein weitere Hardware-Errungenschaft, mit der unter anderem Oculus bereits experimentiert: Variofocal-Displays. Diese benötigen Eye-Tracking als Voraussetzung, da sie sich hier mehrere Displays anhand der Blickrichtung verschoben werden um dem Nutzer die Möglichkeit zu geben, auf bestimmte Punkte in der VR-Umgebung zu fokussieren. Aktuell geben die Softwareentwickler den Fokuspunkt vor – bei einigen Titeln wird der Hintergrund unscharf, lässt sich aber auch nicht durchs Ändern der eigenen Fokussierung scharfstellen wie im echten Leben. Mit Variofocal-Displays schon: Da sich hier der tatsächlich vom Auge fokussierte Bildteil scharfstellt lässt sich unter anderem auch die Ermüdung nach längerer VR-Nutzung verringern.

Zudem sollen Variofocal-Displays für eine bessere Bildqualität sorgen und generell für ein immersiveres VR-Erlebnis sorgen. Mit gewissem Aufwand, die zweite VR-Generation dürfte sich noch nicht durch serienmäßige Variofocal-Displays auszeichnen. Aber vielleicht wird es ja eines der Merkmale der dritten Generation so um 2022 herum.

Fazit

Es bleibt spannend. Momentan sind sehr viele interessante Technologien entweder in der Entwicklung oder bereits serienmäßig erhältlich, die VR noch immersiver aber auch alltagstauglicher machen können. Eye-Tracking erweist sich als unabdingbares Upgrade für Virtual Reality, doch auch Sprachsteuerungen und Fortschritte bei der künstlichen Intelligenz dürften unser VR-Erlebnis in den kommenden Jahren entscheidend verändern. Ob es unbedingt Geruchs-Module wie von Pimax vorgestellt sein müssen – wir wissen es nicht. Hand-Tracking hingegen ist bereits sehr ausgereift und ermöglicht spannende Spielkonzepte.

Sollte Chris Roberts sich an seine Aussagen aus dem Jahre 2012 erinnern und Star Citizen VR- und Handtracking-kompatibel gestalten, könnten wir in einigen Jahren per Wide-FoV-VR kabellos in unserem virtuellen Raumschiff sitzen und die Kontrolldisplays ganz ohne einen Controller zu benötigen mit den eigenen Händen an uns heranziehen. Vielleicht ja sogar per 5G-Stream und wer weiß, vielleicht läuft das Spiel gar nicht auf unserem PC sondern auf einem exorbitant ausgestattetem Cloud-System.

Wie seht ihr die VR-Zukunft? Haben wir etwas vergessen? Schreibt es in die Kommentare oder besucht uns im Discord!

Einige der Links in diesem Artikel sind (unter Umständen) sogenannte Affiliate-Links. Mit einem Kauf über einen dieser Links bekommen wir eine kleine Provision, für euch ändert sich nichts.

Die nächste Brille mit Leap Motion soll ja die Realmax 100 Qian werden (CES 2019) -nach Deinem informativen Test bin ich mal sehr gespannt , wie die ersten Praxistests dieser kombinierten AR – VR Brille werden –

im übrigen vielen Dank für den angenehmen Bericht

Sehr schöne Zusammenfassung momentan relevanter VR-Technologien. Interessant für Einsteiger und VR-Heads wie mich. Mehr davon.

http://lightfield-forum.com/light-field-camera-prototypes/nvidia-near-eye-light-field-display/

diese technik waere der hit .. keine probs mehr mit unnatuerlichen fokussierung der augen auf die displayebene.